本文由 发布,转载请注明出处,如有问题请联系我们! 发布时间: 2021-08-01数据存储设计主要包括哪些-结构化数据存储方式

加载中在演试了规模性运作Druid的考验后,我想对下一代开源系统时间序列分析储存明确提出我的观点,它不应该有Druid原有的难题。

“开源系统”是难题阐述的关键一部分,由于建议的设计方案实质上是特有的Google BigQuery的简单化版本号。我关键是以Dremel的毕业论文和贴子《兜帽下的BigQuery》中得到了有关BigQuery构架的信息内容,也从许多其他来源得到了一些信息内容。

别的总体目标和自我约束:

时间序列分析储存可拓展到单独群集中化的PB级缩小数据信息和100k解决关键。云优先选择:运用云的优点。从数十兆兆字节的数据信息和一千个解决核心逐渐,具备成本效益。在有效经营规模的群集中化,解决低于5 TB数据信息的调查应在3秒之内(p99延迟时间)运作-包含互动式广告分析测试用例。高度一致的查看延迟时间:类似的调查应自始至终耗费同样的时间段来进行,而无论群集中并行处理运作的查看是啥。新摄入的数据信息应该马上可查看。细心想一想:明确提出的设计方案有希望在3-5年之内越来越更加关键,而不是不那麼关键。非总体目标:

当地布署。小规模纳税人的成本效益。任意升级和删掉旧信息的高效率,虽然这种事儿应该是很有可能的。针对一切小的查看,即便在沒有负荷的系统软件中,p99的等待的时间也不上1秒。便于初次布署和系统更新。最后一个导游词格式表明:文中根据在Metamarkets中规模性运作Druid的实践经验和理论基础研究,但所叙述的设计方案并未在生产加工中完成和检测。本文中的一些阐述是不正确的。假如您有一切建议或更改,请在这里贴子下评价!

设计方案简述

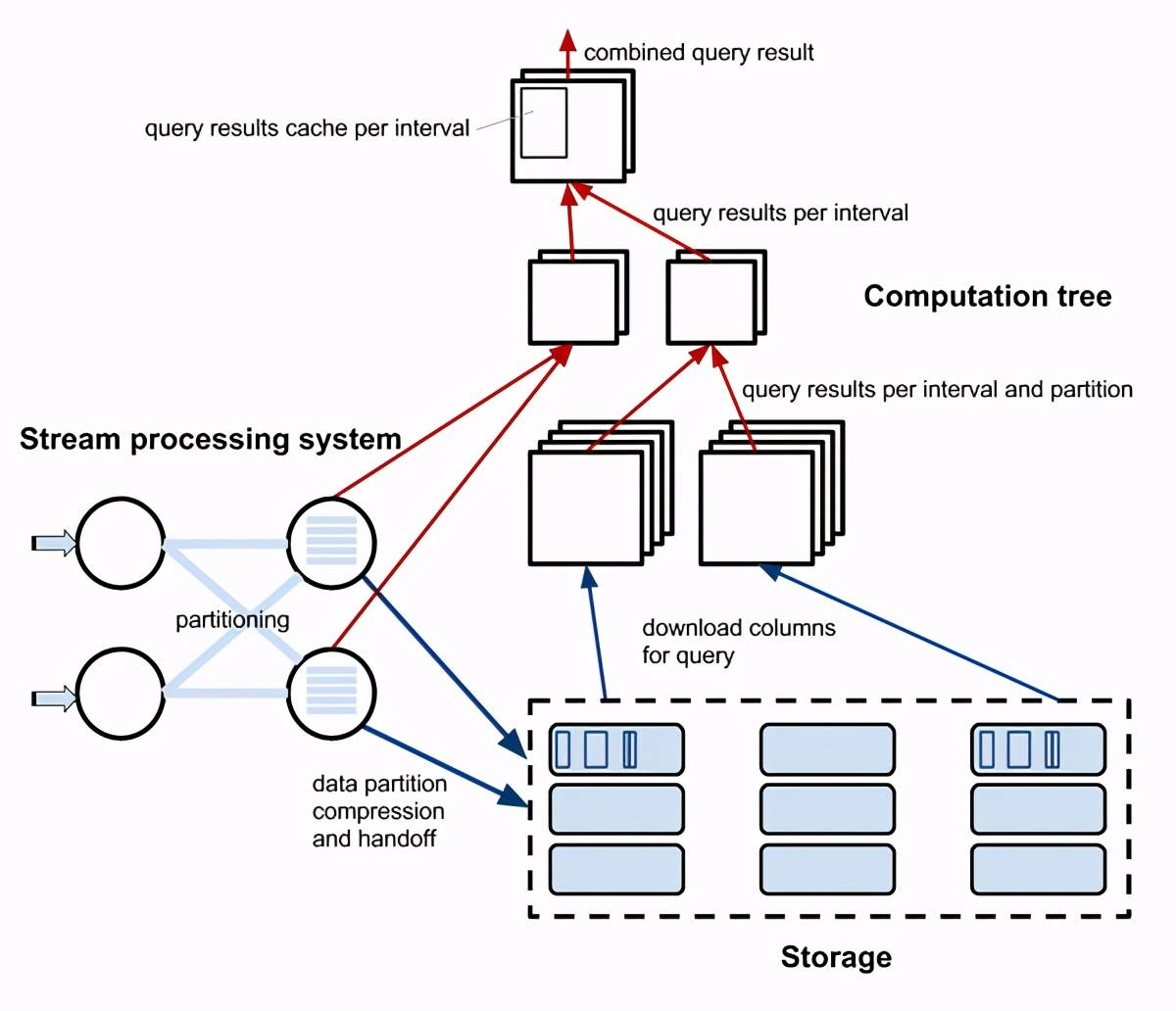

具备三个解耦分系统的时间序列分析储存器设计方案。淡蓝色线框表明未缩小的朝向行的数据流分析;暗蓝色线-缩小柱型数据信息;红杠-查看結果。

具备三个解耦分系统的时间序列分析储存器设计方案。淡蓝色线框表明未缩小的朝向行的数据流分析;暗蓝色线-缩小柱型数据信息;红杠-查看結果。该系统软件由三部份构成,各一部分岗位职责严苛分离出来:步骤解决系统软件.储存和测算树。

流式的系统软件读取数据(接纳“载入”),对其开展系统分区,将每一个间隔时间内的数据交换为缩小的列文件格式,并将其载入储存。步骤解决系统软件的工作员还承担测算最新数据的一部分查看結果。

测算树有好几个等级的连接点:最少等级的连接点从储存免费下载特殊系统分区和间距的数据信息,并且为其测算一部分結果。假如查看间距包括全新的数据信息,则第二层的连接点合拼特殊系统分区的全部系统分区的結果,并接纳底层的连接点和Stream解决系统软件的运行程序流程的接纳。第三层连接点合拼或合拼第二层连接点每一个间隔时间的結果,并包括每一个间隔时间查看結果的缓存文件。这种连接点还很有可能承担群集均衡和较低等测算树的全自动放缩。

该设计方案的关键标准:

测算和储存分离出来。这一念头来源于BigQuery。在我有关野德的内容中,我解读了野德中欠缺这类分开是如何使查看延迟时间不能预估的,由于查看会互相影响。

使测算树中的连接点(基本上)无状态,这代表着他们是“一次性的”。他们可能是amazonEC2或Google的提前案例,比一般案例划算好几倍。相近地,测算树能够在数分钟内被变大和变小,那样就会有很有可能比如.当查看负荷较低时,请在每天晚上和节假日开展减缩。

数据信息捕捉(在流解决操作系统中)与储存分离出来。这一念头事实上早已在野德中完成了,它有即时连接点。这类侧重点的分离出来能够使储存比较简单,不用为获取.列缩小.查询处理等资源分配。它只致力于从硬盘载入字节数块,并根据互联网将他们发送至测算中的连接点和树。

流式的系统软件也很有可能比适用写实际操作的储存更为动态性。流解决设备能够依据数据信息摄入抗压强度的转变按占比变大或变小,一般在晚间和礼拜天较低。流式的系统软件很有可能具备无法在储存中完成的作用,比如动态性重新分区。

是互联网短板。

假如查看的注册量沒有使Storage的转站服务器带宽饱和状态,则互联网对总查看延迟时间的奉献是稳定的,与查看尺寸不相干。如果云阿里云oss被作为储存(参照下边的“云阿里云oss”),或是假如系统软件中的查看负荷相对性于储存中的历史记录量相差太大地小,则能够授于此管理权限。

假如这两个标准都不适合,能够应用Storage来安装一些免费下载頻率较低的非时序数据,进而人为因素提升Storage群集的经营规模,从而提升其出站服务器带宽。

不然,在所确立的制定中,储存和测算树中间的互联网货运量很有可能变成限定查看延迟时间的要素。有几种方式还可以减轻这个状况:

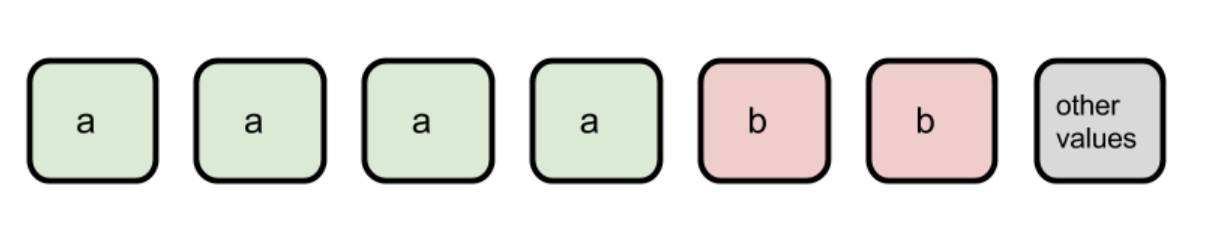

与仅转化成一个表的典型性SQL查看不一样,对该体系的调查应构成全部子查询,而这种子查询是在剖析设计的单独显示屏上所需的。Analytics(剖析)页面一般包含最少好多个,有时候是几十个表,数据图表等,他们是同一时间序列分析数据信息的子查询的結果。在第三级测算树中慷慨大方地缓存文件查看結果,以降低改版同样测算的负荷。投射下推:仅从储存区免费下载查询处理需要的列非空子集。按层面键系统分区(最常发生在查看过滤装置中)仅免费下载和解决需要的系统分区-谓词下推式。因为很多具体数据信息层面中的密匙頻率是Poisson-,Zipf-或别的不分布均匀的,因而理想化状况下,Stream解决系统软件应适用“一部分”系统分区,请参照下面的图。因为这类系统分区的数量较低,因而能够在每个系统分区越来越过小而没法以列文件格式和解决开展有效的缩小以前,将数据信息按好几个方面开展系统分区。

一部分系统分区能够实行不匀称的密匙分派。每一个小盒子全是一个挡板。具备“别的值”的系统分区很有可能有数千个“长尾关键词”值。

更一般而言,数据信息段(系统分区)的数据库应包含相关全部层面的信息内容,该层面好像在这里系统分区中仅添充了一个(或非常少)键,进而能够从“出现意外”系统分区中获益。离子交换柱缩小应明显适用压缩系数,而不是缓解压力或响应速度。列数据信息需从储存流式传输到测算树中的连接点,而且一旦全部必不可少列的第一个块抵达测算连接点,就逐渐子查询处理。那样能够使网站和CPU的功绩在总查看延迟时间中尽量地重合。要从这当中获益,将列从储存发送至测算树的先后顺序应当比仅在储存中的硬盘上排序列的次序或列名字按字母顺序排序的次序更聪慧。列还可以按一小块以交叠次序推送,而不是逐列推送。一旦一部分結果就绪,就增长测算最后查看結果,并将增加量結果流式传输到手机客户端,以使手机客户端认知查看运作得迅速。在文中的最终,我将详解系统软件的不同一部分。

援救

在这节中,我觉得进行一些有可能的储存完成。他们能够做为可交换的选择项并存,如同在野德中一样。

云储存。

它是amazonS3.谷歌云储存(GCS).Azure Blob储存和别的云服务商的相近商品。

从定义上而言,这恰好是设计方案好的时间序列分析储存应当采用的储存方法,由于GCS是由一个名叫巨像的软件不支持的,与此同时也是BigQuery的储存层。

云储存比我下面要探讨的选择项划算得多,必须的管理也少得多,并且货运量基本上是无穷的,因此上边的全部“互联网是短板”一部分在较大水平上是无关痛痒的(理论上)。

云储存API不足健全,没法适用单独要求中的好几个字节数免费下载(针对两列的投射下推),因此每列的每一次免费下载都应该是一个独立的要求。我怀疑这不是BigQuery的工作方式,它与巨像的集成化更为密切,能够完成适度的两列投射下推。

我认为,“云阿里云oss”选择项的具体缺陷可能是其p99延迟时间和货运量。一些标准测试表明,GCS和S3在100 ms延迟时间中有p99延迟时间(能够接纳),货运量仅受免费下载VM作用的限定。可是要是在100个高并发负荷的情形下或是那样,我能对一个连接点的要求和全部群集一百万个高并发要求的范围觉得十分诧异。一定要注意,全部云服务提供商也没有阿里云oss延迟时间和货运量的SLA,而且认可货运量针对GCS而言是“一个非常大的自变量”。

(注:以前我还在上边一节提及,云阿里云ossAPI不兼容范畴要求,这也是错误的,尽管许多人依然不兼容单独要求中的好几个范畴免费下载(截止到2019年10月),因此高并发查看的变大因素不容易消退。)

HDFS的地砖拼花数据信息系统分区。

这一选择项的关键特点是它与Hadoop生态体系的其余一部分非常好地集成化在一起——测算树乃至能够“额外”到一些目前的数据库管理上。不宜时间序列分析案例的繁杂查看,如大中型联接或多步查看,能够由坐落于同一HDFS群集顶端的Spark.Impala.Hive或Presto等系统软件解决。

一样关键的是,致力于布署设计方案的时间序列分析储存的机构很有可能早已有着一个十分大的HDFS群集,该群集具备较大的转站服务器带宽,假如时间序列分析储存应用这一HDFS群集来储存其数据信息系统分区,它很有可能会紧紧围绕互联网的扩展性工作中。

可是,明细HDFS根据单独名字连接点路由器全部载入要求。100k个高并发读要求(假定在预估树中的一个连接点上下载一个数据信息系统分区只要一个读要求)贴近NameNode的肯定扩展性限定。因而,假如HDFS集群事实上忙碌一些內容,与时间序列分析储存不相干的实际操作将超出此限定。

除此之外,当HDFS被作为“远程控制”分布式存储时,即便针对Parquet格式的文档,它也不兼容投射下推,因而全部数据信息系统分区应当由测算树中的连接点免费下载。假如时间序列分析数据信息中有百余列,一般仅有一小部分用以查看,結果会很差。正众多阿里云oss所提议的,每一个数据信息系统分区的每一列都变成了一个独立的文档,这提升了资料和载入要求的总数,进而增加了很大的可扩展性限定。名字连接点将没法解决一百万个高并发要求,而且HDFS沒有对于低于10 MB的文档开展提升。假定最好数据信息系统分区尺寸约为一百万,数据信息系统分区的每一列都将有尺寸为的行。

可是,在某种情形下(比如,有很多未灵活运用的HDFS群集),在一些具体状况下,HDFS好像是更具成本效益的挑选,而且感觉优良。

阿帕奇库杜

Apache Kudu是一个列数据储存,致力于许多状况下取代HDFS 地砖拼花对。它融合了空中间节约列储存和迅速单行读写能力的工作能力。实际上,设计方案的时间序列分析系统软件不用第二一部分,由于载入是由Stream解决系统软件解决的,大家期待使Storage更划算,不消耗CPU(比如,用以后台管理缩小每日任务)。每一个储存连接点上的运行内存和硬盘資源适用单行读写能力。除此之外,Kudu中旧数据信息的单行载入必须在Kudu连接点上开展系统分区缓解压力。在明确提出的时间序列分析储存设计方案中,仅有缩小数据信息应当在储存和测算树中间传送。

另一方面,库都是有许多吸引住时间序列分析系统软件的作用,而HDFS沒有:

类似RDBMS的词义。Kudu中的数据信息以报表的方式机构,而不单单是一堆文档。Kudu中的平板网络服务器(连接点)比HDFS中的网络服务器更单独,进而能够在开展载入时绕开查看主连接点(Kudu等效于NameNode),进而进一步提高了载入扩展性。投射下推。它是用C 撰写的,因而尾端延迟时间应当相比Java撰写而且会发生GC中止的HDFS更强。依据Kudu的毕业论文,理论上很有可能适用可插下的储存合理布局。假如执行的储存合理布局放弃了Kudu对获取单行载入和旧数据信息载入的适用,反而是更合适时间序列分析储存设计方案,那麼Kudu很有可能会变成比HDFS更强的储存挑选。

卡桑德拉或锡拉。

在像Cassandra那样的系统软件中,每一个数据信息系统分区都能够储存在一个内容中。从Cassandra的视角看来,列具备二进制种类,而且储存数据信息系统分区的缩小列。

这一按钮与Kudu有很多一同的优势,乃至有更强的优势:出色的载入可扩展性,非常低的延迟时间(尤其是应用ScyllaDB的情形下),表词义及其只免费下载所需列的工作能力(投射下推)。

另一方面,像Cassandra那样的系统软件并不是为好几个MB列值和大概100 MB的总公司尺寸而制定的,而且在添充该类数据信息时很有可能会逐渐碰到实际操作难题。除此之外,他们不兼容单独行乃至单独行中的单独列等级的流载入,可是他们能够在这种系统软件中相对性非常容易地完成。

Cassandra是为了更好地承担高载入负荷而制定的,因而在时钟频率系统软件中应用相近LSM的存储结构和很多运行内存做为储存会使资源被浪费。

和我上边建立的别的选择项对比,这一选择项速率更快,但成本效益最少。

器重测算树的时间做为储存(2019年加上)。

请参照这儿的念头阐述。https://GitHub.com/apache/druid/issues/8575

流解决系统软件

如上所述,Druid早已在说白了的数据库索引分系统或即时连接点中区别了数据获取和储存。殊不知,虽然数据库索引分系统完成了分布式系统流解决系统软件的作用的一个详细非空子集,但它并未运用这种工作中的任意一个,乃至沒有运用任务管理器,如Mesos或YARN,而且一切都是在Druid源码中进行的。野德的数据库索引分系统的效果远小于当代流解决系统软件,因为它的开发设计工作中要少几十倍。

相近地,在Druid以前,时间序列分析数据信息一般在别的流解决操作系统中被组成或丰富多彩。比如,沃尔玛超市根据Storm保证了这一点,而Metamarkets出自于相近的目标应用Samza。实质上,这代表着2个单独的流解决系统软件在数据信息管路中一个接一个地运作,进而防止了投射运算符和Druid的获取终端设备运算符的结合,这也是流解决操作系统中常用的提升。

这就是为啥觉得在下一代时间序列分析中,数据信息获取应当灵活运用一些目前的流解决系统软件。

流解决系统软件必须与别的时间序列分析储存密切集成化,比如,容许测算树中的连接点查看流解决操作系统中的运行程序流程。这代表着与储存不一样,它很有可能无法适用好几个流解决系统软件。只需挑选一个并与时间序列分析信息系统集成。

弗林克,飓风和苍鹭全是很有可能的侯选人。现阶段难以分辨哪一种技术性更合适,或是哪一种技术性更合适,由于这类新项目能够更快地相互之间拷贝原素。假如设计方案的时间序列分析系统软件事实上是在机构中建立的,则挑选很有可能在于机构中早已应用的步骤解决系统软件。

阅读文章野德开发设计邮件归档中的主题风格,掌握更多的有关这一主题风格的信息内容。

测算树

我系统对这一部分的外型沒有很大的难题。上边的“设计方案简述”一部分详细介绍了一些有可能的方式。

这类方式最少有一个难题:假如必须缓存文件过多的查看結果,测算树第三(最大)层的连接点将没法高效解决特殊时间序列分析(表)的查看。为了更好地自始至终将类似的子查询(在全部查看间距中仅有不一样的子查询)路由器到同一个连接点并捕捉缓存文件的結果,一个包括好几个子查询的“复合型”查看应当溶解为好几个单独的查看,随后应用nas存储和测算树中间的高效率较低:请参照里面的“互联网是短板”一节,这也是此目录中的第一项。

殊不知,第三级测算树中的通道能够在竖直方位上拓展,令其其充足大来解决全部查看,并容下一切单独时间序列分析(乃至最忙碌的时间序列分析)的全部缓存文件。

竖直拓展代表着第三级测算树中的一个连接点应当解决很多高并发查看。这也是我们觉得假如重新开始搭建测算树,应当挑选多线程网站架构而不是堵塞的因素之一(还可以应用Go式的翠绿色进程)。此外2个缘故是:

第一层测算树中的时间根据储存实行很多的互联网I / O。这种连接点上的测算在于来源于Storage的数据到达,并具备不能预见的延迟时间:来源于Storage的参数要求一般会有再次排列的回应。测算树全部等级的框架都应适用增加量查看結果测算,并很有可能以较长的间距回到同一查看的好几个結果。以上文“互联网是短板”一节上述,它使系统软件更具有容错机制工作能力(在我的第一篇文章内容中探讨了运作Druid的挑戰),并使其越来越更快。服务平台

理想化状况下,搭建测算树的程序编写服务平台需要具备下列特点:

适用运作时代码生成,以使查看迅速地进行并提升CPU使用率。这篇相关Impala中运作时代码生成的网络文章对于此事开展了不错的表述。出自于同样的缘故,转化成的设备编码应该是“最好”的,并在可能的情形下开展矢量化解决。较低的堆/目标运行内存花销,由于运行内存价格昂贵,因而使测算树中的连接点更划算。自始至终较短的垃圾分类回收中止(针对具备代管运行内存的服务平台),以适用设计方案的时间序列分析储存的“一致查看延迟时间”总体目标。从纯科技的视角看来,C 是大赢家,它能够达到全部这种规定。挑选与特性不相干的C 的弊端也是毫无疑问的:开发设计速率,调节,用软件构架拓展系统软件十分艰难。

JVM或是一个很好的挑选,坚信这一系统软件的高效率很有可能比C 内嵌的系统软件低不超过20%:

JVM容许配用JITc语言编译器以做到与运作时代码生成总体目标同样的实际效果。针对时间序列分析解决,关键在列压缩包解压期内及其在数据信息上运作特殊汇聚时必须编码矢量化。两者都能够在JNI涵数中进行。当以数十千字节的压缩包解压数据信息付款一次时,JNI的花销相对性较小(大家很有可能期待以这类尺寸的块开展解决以合适L2缓存文件中的全部压缩包解压数据信息)。巴拉马新项目将使此花销更小。假如将数据储存在堆外运行内存中并做好解决,则垃圾分类回收的JNI含意也不大或压根不会有。能够根据将全部互联网IO,数据储存,缓存和解决都放到堆外运行内存中,进而使堆内存不大,进而仅对每一个查看分派一些堆。应用Shenandoah GC能够减少废弃物搜集的暂停时间。假如关键解决循环系统中采用的全部算法设计都是是非非堆分派的,则堆内存的载入和载入阻碍不容易对CPU使用率导致很大危害。根据我所知道,尽管Go或Rust现阶段不兼容运作时代码生成,但加上那样的鼓励很有可能不用过多的黑客入侵:有关Rust的难题,请参照gojit新项目和StackOverflow。针对别的标准,Go的进行时和转化成的编码很有可能高效率较低,但因为一些非技术性缘故,它比Rust更高效率。