本文由 发布,转载请注明出处,如有问题请联系我们! 发布时间: 2021-07-24YARN调度器(Scheduler)详解

加载中

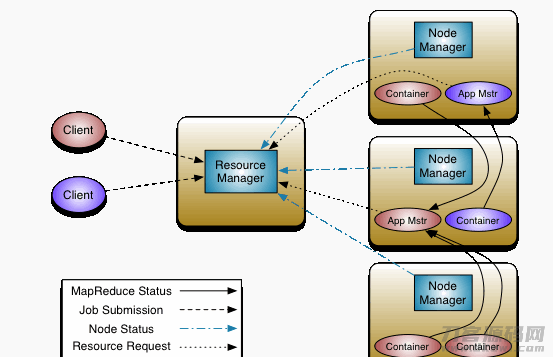

理想化状况下,大家运用对Yarn資源的要求应当马上获得达到,但现实状况資源通常是比较有限的,特别是在一个很忙碌的群集,一个运用資源的要求常常必须 等候一段时间才可以的到相对应的資源。在Yarn中,承担给运用资源分配的便是Scheduler。实际上 生产调度自身便是一个难点,难以寻找一个极致的对策能够 处理全部的应用领域。因此,Yarn给予了多种多样生产调度器和可配备的对策供大家挑选。YARN构架以下:

- ResourceManager(RM):承担对各NM上的資源开展统一管理方法和生产调度,将AM分派空余的Container运作并监管其运作情况。对AM申请办理的資源要求分派相对应的空余Container。关键由2个部件组成:生产调度器(Scheduler)和运用程序管理器(Applications Manager)。

- 生产调度器(Scheduler):生产调度器依据容积、序列等限定标准(如每一个序列分派一定的資源,数最多实行一定总数的工作等),将系统软件中的资源配置给每个已经运作的应用软件。生产调度器仅依据每个应用软件的資源要求开展资源配置,而资源配置企业是Container,进而限制每一个每日任务应用的资源储存量。Scheduler不承担监管或是追踪应用软件的情况,都不承担每日任务由于各种各样缘故而必须 的重新启动(由ApplicationMaster承担)。总而言之,生产调度器依据应用软件的資源规定,及其群集设备的資源状况,为用程序流程分派封裝在Container中的資源。生产调度器是可插下的,比如CapacityScheduler、FairScheduler。(PS:在具体运用中,只必须 简易配备就可以)

- 运用程序管理器(Application Manager):运用程序管理器部门管理全部系统软件中全部应用软件,包含应用软件递交、与生产调度器商议資源以运行AM、监管AM运作情况并在不成功时重启等,追踪分到的Container的进展、情况也是其岗位职责。ApplicationMaster是运用架构,它承担向ResourceManager融洽資源,而且与NodeManager协调工作进行Task的实行和监管。MapReduce便是原生态适用的一种架构,能够 在YARN上运作Mapreduce工作。有很多分布式架构都开发设计了相匹配的应用软件架构,用以在YARN上运作每日任务,比如Spark,Storm等。假如必须 ,大家还可以自身写一个符合要求的YARN application。

- NodeManager(NM):NM是每一个连接点上的資源和资源管理器。它会按时地为RM报告本连接点上的資源应用状况和每个Container的运作情况;与此同时会接受并解决来源于AM的Container 运行/终止等要求。ApplicationMaster(AM):客户递交的应用软件均包括一个AM,承担运用的监管,追踪运用实行情况,重新启动不成功每日任务等。

- Container:是YARN中的資源抽象性,它封裝了某一连接点上的多层次資源,如运行内存、CPU、硬盘、互联网等,当AM向RM申请办理資源时,RM为AM回到的資源就是用Container 表明的。YARN会为每一个分配任务一个Container且该每日任务只有应用该Container中叙述的資源。

1. Yarn生产调度器详细介绍

1.1. FIFO Scheduler(先进先出法生产调度器)

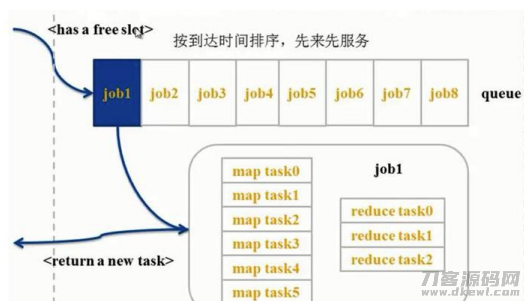

FIFO Scheduler把运用按递交的次序排列成一个序列,这是一个先进先出法序列,在开展资源配置的情况下,先给序列中最头顶的运用开展资源分配,待最头顶的运用要求达到后再给下一个分派,依此类推。FIFO Scheduler是非常简单也是最非常容易了解的生产调度器,也不用一切配备,但它并不适感用以共享资源群集。大的运用很有可能会占有全部群集資源,这就造成其他运用被堵塞。在共享资源群集中,更合适选用Capacity Scheduler或Fair Scheduler,这两个生产调度器都容许大每日任务和日常任务在递交的与此同时得到 一定的服务器资源。下边“Yarn生产调度器对比分析”展现了这好多个生产调度器的差别,从图上能够 看得出,在FIFO 生产调度器中,日常任务会被大每日任务堵塞。

1.2.Capacity Scheduler(容积生产调度器)

yarn-site.xml中默认设置配备的資源生产调度器。而针对Capacity生产调度器,有一个专业的序列用于运作日常任务,可是为日常任务专业设定一个序列会事先占有一定的群集資源,这就造成大每日任务的实行時间会落伍于应用FIFO生产调度器时的時间。用这一資源生产调度器,就可以配备yarn資源序列,这一后边后详细介绍采用。

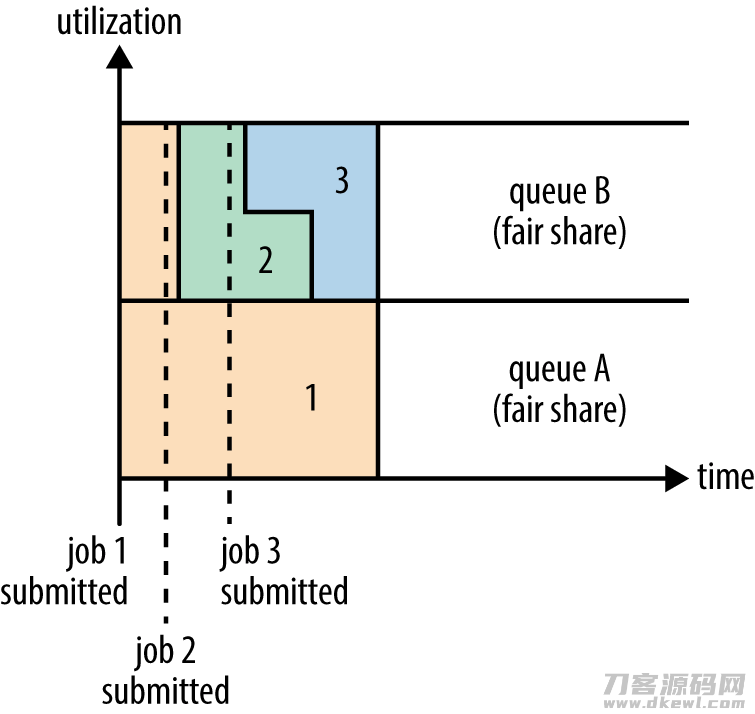

1.3. Fair Scheduler(公平公正生产调度器)

Fair生产调度器的设计方案总体目标是为全部的运用分派公平公正的資源(对公平公正的界定能够 根据主要参数来设定)。在上面的“Yarn生产调度器对比分析”展现了一个序列中2个运用的公平公正生产调度;自然,公平公正生产调度在还可以在好几个序列间工作中。举个事例,假定有两个客户A和B,她们各自有着一个序列。当A运行一个job而B沒有每日任务时,A会得到 所有群集資源;当B运行一个job后,A的job会再次运作,但是一会儿以后2个每日任务会分别得到 一半的群集資源。假如这时B重新启动第二个job而且其他job仍在运作,则它可能和B的第一个job共享资源B这一序列的資源,也就是B的2个job会用以四分之一的群集資源,而A的job依然用以群集一半的資源,結果便是資源最后在2个客户中间公平的共享资源。在Fair生产调度器中,大家不用事先占有一定的服务器资源,Fair生产调度板会为全部运作的job动态性的调节服务器资源。当第一个大job递交时,仅有这一个job在运作,这时它得到 了全部群集資源;当第二个日常任务递交后,Fair生产调度板会分派一半資源给这一日常任务,让这两个每日任务公平公正的共享资源群集資源。

a) 公平公正生产调度器,便是可以共享资源全部群集的資源

b) 无需事先占有資源,每一个工作全是共享资源的

c) 每每递交一个工作的情况下,便会占有全部資源。假如再递交一个工作,那麼第一个工作便会分到第二个工作一部分資源,第一个工作也就释放出来一部分資源。再递交别的的工作时,也同样。。。。换句话说每一个工作进去,都是有机遇获得資源。

1.4. Fair Scheduler与Capacity Scheduler差别

- 資源公平公正共享资源:在每一个序列中,Fair Scheduler可挑选依照FIFO、Fair或DRF对策为应用软件资源分配。Fair对策即平分,默认设置状况下,每一个序列选用该方法资源分配

- 适用資源占领:当某一序列中有剩下資源时,生产调度板会将这种共享资源给别的序列,而当该序列中有新的应用软件递交时,生产调度器要为它回收利用資源。为了更好地尽量减少多余的测算消耗,生产调度器选用了先等候再强制性回收利用的对策,即假如等候一段时间后还有未偿还的資源,则会开展資源占领;从这些超量应用資源的序列中杀掉一部分每日任务,从而释放出来資源

- web服务:Fair Scheduler给予了一个根据每日任务数的web服务体制,该体制尽量将系统软件中的每日任务匀称分派到每个连接点上。除此之外,客户还可以依据自身的要求设计方案web服务体制

- 生产调度对策灵便配备:Fiar Scheduler容许管理人员为每一个序列独立设定生产调度对策(当今适用FIFO、Fair或DRF三种)

- 提升 小应用软件响应速度:因为选用了较大 最少公平公正优化算法,小工作能够 迅速获得資源并运作进行

2.Yarn生产调度器配备

yarn資源生产调度器是在yarn-site.xml中配备。

2.1. FairScheduler

Fair Scheduler的配备选择项包含两一部分:

一部分在yarn-site.xml中,关键用以配备生产调度器等级的主要参数

一部分在一个自定环境变量(默认设置是fair-scheduler.xml)中,关键用以配备每个序列的资源储存量、权重值等信息内容。

2.1.1 yarn-site.xml

yarn-site.xml详细介绍

<!– scheduler start –>

<property>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</value>

<description>配备Yarn应用的生产调度器软件类名;Fair Scheduler相匹配的是:org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</description>

</property>

<property>

<name>yarn.scheduler.fair.allocation.file</name>

<value>/etc/hadoop/conf/fair-scheduler.xml</value>

<description>配备资源池及其其特性配额制的XML文件路径(当地途径)</description>

</property>

<property>

<name>yarn.scheduler.fair.preemption</name>

<value>true</value>

<description>打开資源占领,default is True</description>

</property>

<property>

<name>yarn.scheduler.fair.user-as-default-queue</name>

<value>true</value>

<description>设成true,当每日任务中未找到资源池的情况下,将以登录名做为资源池名。这一配备就完成了依据登录名全自动分派资源池。default is True</description>

</property>

<property>

<name>yarn.scheduler.fair.allow-undeclared-pools</name>

<value>false</value>

<description>是不是容许建立未定义的资源池。假如设成true,yarn可能全自动建立每日任务中特定的未定义过的资源池。设成false以后,每日任务中特定的未定义的资源池将失效,该每日任务会被分派到default资源池中。,default is True</description>

</property>

<!– scheduler end –>

2.1.2 fair-scheduler.xml

假定在工作环境Yarn中,一共有四类客户必须 应用群集,production、spark、default、streaming。为了更好地使其递交的每日任务不受影响,我们在Yarn上整体规划配备了四个资源池,各自为production,spark,default,streaming。并依据具体业务流程状况,为每一个资源池分派了相对应的資源及优先等,default用以软件开发测试目地.

ResourceManager上fair-scheduler.xml配备以下:

<?xml version="1.0"?>

<allocations>

<queue name="root">

<aclSubmitApps></aclSubmitApps>

<aclAdministerApps></aclAdministerApps>

<queue name="production">

<minResources>8192mb,8vcores</minResources>

<maxResources>419840mb,125vcores</maxResources>

<maxRunningApps>60</maxRunningApps>

<schedulingMode>fair</schedulingMode>

<weight>7.5</weight>

<aclSubmitApps>*</aclSubmitApps>

<aclAdministerApps>production</aclAdministerApps>

</queue>

<queue name="spark">

<minResources>8192mb,8vcores</minResources>

<maxResources>376480mb,110vcores</maxResources>

<maxRunningApps>50</maxRunningApps>

<schedulingMode>fair</schedulingMode>

<weight>1</weight>

<aclSubmitApps>*</aclSubmitApps>

<aclAdministerApps>spark</aclAdministerApps>

</queue>

<queue name="default">

<minResources>8192mb,8vcores</minResources>

<maxResources>202400mb,20vcores</maxResources>

<maxRunningApps>20</maxRunningApps>

<schedulingMode>FIFO</schedulingMode>

<weight>0.5</weight>

<aclSubmitApps>*</aclSubmitApps>

<aclAdministerApps>*</aclAdministerApps>

</queue>

<queue name="streaming">

<minResources>8192mb,8vcores</minResources>

<maxResources>69120mb,16vcores</maxResources>

<maxRunningApps>20</maxRunningApps>

<schedulingMode>fair</schedulingMode>

<aclSubmitApps>*</aclSubmitApps>

<weight>1</weight> <aclAdministerApps>streaming</aclAdministerApps>

</queue>

</queue>

<user name="production">

<!-- 针对特殊客户的配备:production数最多能够 与此同时运作的每日任务 -->

<maxRunningApps>100</maxRunningApps>

</user>

<user name="default">

<!-- 针对默认设置客户配备数最多能够 与此同时运作的每日任务 -->

<maxRunningApps>10</maxRunningApps>

</user>

<!-- users max running apps -->

<userMaxAppsDefault>50</userMaxAppsDefault>

<!--默认设置的客户数最多能够 与此同时运作的每日任务 -->

<queuePlacementPolicy>

<rule name="specified"/>

<rule name="primaryGroup" create="false" />

<rule name="secondaryGroupExistingQueue" create="false" />

<rule name="default" queue="default"/>

</queuePlacementPolicy>

</allocations>

主要参数详细介绍:

- minResources:至少資源确保量,设定文件格式为“X mb, Y vcores”,当一个序列的至少資源确保量未达到时,它将优先选择于别的平级序列得到 資源,针对不一样的生产调度对策(后边会详解),至少資源确保量的含意不一样,针对fair对策,则只考虑到运行内存資源,即假如一个序列应用的运行内存資源超出了它的至少资源储存量,则觉得它已获得了达到;针对drf对策,则考虑到主資源应用的资源储存量,即假如一个序列的主资源储存量超出它的至少资源储存量,则觉得它已获得了达到。

- maxResources:数最多能够 应用的资源储存量,fair scheduler会确保每一个序列应用的资源储存量不容易超出该序列的数最多可应用资源储存量。

- maxRunningApps:数最多与此同时运作的应用软件数量。根据限定该数量,可避免超额Map Task与此同时运作时造成的正中间輸出結果撑爆硬盘。

- weight:资源池权重值,关键用在共享资源之时,weight越大,取得的資源越多。例如一个pool中有20GB运行内存用不上,此刻能够 共享资源给别的pool,别的每一个pool拿是多少,便是由权重值决策的

- aclSubmitApps:可向序列中递交应用软件的Linux客户或用户群目录,默认设置状况下为“*”,表明一切客户均能够 向该序列递交应用软件。必须 留意的是,该特性具备传递性,即子序列的目录会承继父序列的目录。配备该特性时,客户中间或用户群中间用“,”切分,客户和用户群中间用空格符切分,例如“user1, user2 group1,group2”。

aclAdministerApps:容许管理方法每日任务的登录名和组;一个序列的管理人员可管理方法该序列中的資源和应用软件,例如可杀掉随意应用软件。 - minSharePreemptionTimeout :最少共享资源量占领時间。假如一个资源池在该時间内应用的资源储存量一直小于最少资源储存量,则逐渐占领資源。

- schedulingMode/schedulingPolicy:序列选用的生产调度方式,能够 是fifo、fair或是drf。

管理人员也能为单独客户加上maxRunningJobs属性限定其数最多与此同时运作的应用软件数量。除此之外,管理人员也可根据下列基本参数之上特性的初始值: - userMaxJobsDefault:客户的maxRunningJobs属性的初始值。

- defaultMinSharePreemptionTimeout :序列的minSharePreemptionTimeout特性的初始值。

- defaultPoolSchedulingMode:序列的schedulingMode特性的初始值。

- fairSharePreemptionTimeout:公平公正共享资源量占领時间。假如一个资源池在该時间内应用资源储存量一直小于公平公正共享资源量的一半,则逐渐占领資源。

那样,每一个用户群下的客户递交每日任务情况下,会到相对应的资源池中,而不危害别的业务流程。序列的层级是根据嵌入原素完成的。全部的序列全是root序列的小孩,即便沒有配到 原素里。Fair生产调度器中的序列有一个权重值特性(这一权重值便是对公平公正的界定),并把这个特性做为公平公正生产调度的根据。在这个事例中,当生产调度器分派群集7.5,1,1,0.5資源给production,spark,streaming,default时便看作公平公正,这儿的权重值并并不是百分数。留意,针对在沒有环境变量时按客户全自动建立的序列,他们仍有权重值而且权重为1。每一个序列內部仍能够 有不一样的生产调度对策。序列的默认设置生产调度对策能够 根据顶尖原素 开展配备,要是没有配备,默认设置选用公平公正生产调度。虽然是Fair生产调度器,其仍适用在序列等级开展FIFO生产调度。每一个序列的生产调度对策能够 被其內部的 原素遮盖,在上面这一事例中,default序列就被特定选用fifo开展生产调度,因此,针对递交到default序列的每日任务就可以依照FIFO标准次序的实行了。必须 留意,spark,production,streaming,default中间的生产调度依然是公平公正生产调度。每一个序列可配备较大 、最少資源占有数和较大 可运作的运用的总数。

Fair生产调度器选用了一套根据标准的系统软件来明确运用应当放进哪一个序列。在上面的事例中,

自然,我们可以不配备queuePlacementPolicy标准,生产调度器则默认设置选用以下标准:

<queuePlacementPolicy>

<rule name="specified" />

<rule name="user" />

</queuePlacementPolicy>

上边标准意思是除非是序列被精确的界定,不然会以客户名叫序列名建立序列。还有一个简易的配备对策能够 促使全部的运用放进同一个序列(default),那样就可以让全部运用中间公平共享资源群集而不是在客户中间。这一配备的界定以下:

<queuePlacementPolicy>

<rule name="default" />

</queuePlacementPolicy>

完成上边作用大家还能够不应用环境变量,立即设定yarn.scheduler.fair.user-as-default-queue=false,那样运用便会被放进default 序列,而不是每个登录名序列。此外,大家还能够设定yarn.scheduler.fair.allow-undeclared-pools=false,那样客户就没法建立序列了。

当一个job递交到一个忙碌群集中的空序列时,job并不会立刻实行,只是堵塞直至已经运作的job释放出来服务器资源。为了更好地使递交job的实行時间更具有预测性(能够 设定等候的请求超时時间),Fair生产调度器适用占领。占领便是容许生产调度器干掉占有超出其应占市场份额資源序列的containers,这种containers資源便可被分派到应当具有这种市场份额資源的序列中。必须 留意占领会减少群集的实行高效率,由于被停止的containers必须 被再次实行。能够 根据设定一个全局性的主要参数yarn.scheduler.fair.preemption=true来开启占领作用。除此之外,也有2个主要参数用于操纵占领的到期時间(这两个主要参数默认设置沒有配备,必须 最少配备一个来容许占领Container):

minSharePreemptionTimeout

fairSharePreemptionTimeout

假如序列在minimum share preemption timeout特定的時间内未得到 最少的資源确保,生产调度器便会占领containers。我们可以根据环境变量中的顶尖原素

与之相近,假如序列在fair share preemption timeout特定時间内未得到 公平的資源的一半(这一占比能够 配备),生产调度器则会开展占领containers。这一请求超时時间能够 根据顶尖原素

必须 留意的是,全部手机客户端递交每日任务的客户和用户群的对应关系,必须 维护保养在ResourceManager上,ResourceManager在分派资源池情况下,是以ResourceManager上载入客户和用户群的对应关系的,不然便会被分派到default资源池。在日志中发生”UserGroupInformation: No groups available for user”相近的警示。而手机客户端设备上的客户相匹配的用户群无关痛痒。

每一次在ResourceManager上增加客户或是调节资源池配额制后,必须 实行下边的指令更新使其起效.

yarn rmadmin -refreshQueues

yarn rmadmin -refreshUserToGroupsMappings

动态更新只适用改动资源池配额制,如果是增加或降低资源池,则必须 重新启动Yarn群集.

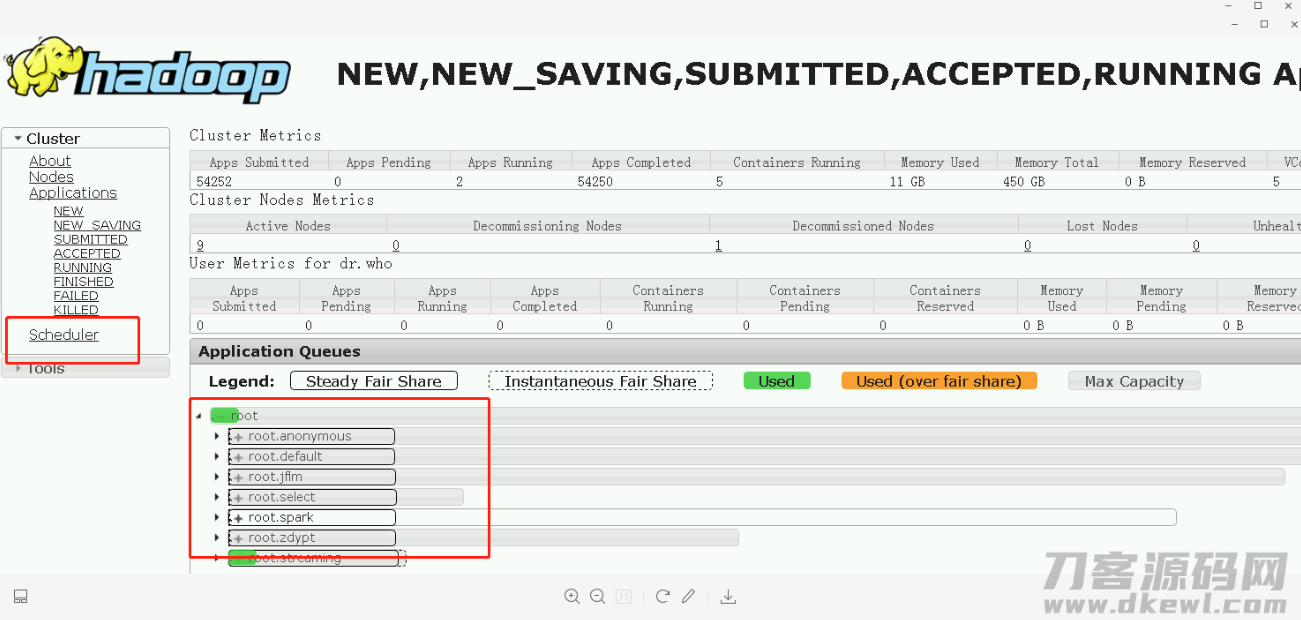

Fair Scheduer各资源池配备及应用状况,在ResourceManager的WEB监管网页页面上还可以见到: http://ResourceManagerHost:8088/cluster/scheduler

2.2 Capacity Scheduler配备(默认设置配备)

hadoop2.7默认设置应用的是Capacity Scheduler容积生产调度器

yarn-site.xml

<property>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.capacity.CapacityScheduler</value>

</property>

Capacity 生产调度器容许好几个机构共享资源全部群集,每一个机构能够 得到 群集的一部分计算水平。根据为每一个机构分派专业的序列,随后再为每一个序列分派一定的群集資源,那样全部群集就可以根据设定好几个序列的方法给好几个机构给予服务项目了。此外,序列內部又可以竖直区划,那样一个机构內部的好几个组员就可以共享资源这一序列資源了,在一个序列內部,資源的生产调度是选用的是先进先出法(FIFO)对策。

一个job很有可能应用不上全部序列的資源。殊不知假如这一序列中运作好几个job,假如这一序列的資源足够,那麼就分派给这种job,假如这一序列的資源不足用了呢?实际上 Capacity生产调度器仍很有可能分派附加的資源给这一序列,这就是“延展性序列”(queue elasticity)的定义。

在一切正常的实际操作中,Capacity生产调度器不容易强制性释放出来Container,当一个序列資源不足用时,这一序列只有得到 其他序列释放出来后的Container資源。自然,我们可以为序列设定一个最大资源需求量,以防这一序列太多的占有空余資源,造成其他序列没法应用这种空余資源,这就是”延展性序列”必须 衡量的地区。

假定大家有以下层级的序列:

root

├── prod

└── dev

├── eng

└── science

下边是一个简易的Capacity生产调度器的环境变量,文件夹名称为capacity-scheduler.xml。在这个配备中,在root序列下边界定了三个子序列prod和dev,各自占40%和60%的容积。必须 留意,一个序列的配备是根据特性yarn.sheduler.capacity.

<?xml version="1.0"?>

<configuration>

<property>

<name>yarn.scheduler.capacity.root.queues(/&eae)

<value>prod,dev</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.queues</tta*e>

<value>eng,science</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.prod.capacity</name>

<value>40</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.capacity</name>

<value >60</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.maximuin-capacity</name>

<value>75</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.eng.capacity</name>

<value >50</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.science.capacity</name>

<value >50</value>

</property>

</configuration>

我们可以见到,dev序列又被分为了eng和science2个同样容积的子序列。dev的maximum-capacity特性被设成了75%,因此即便prod序列彻底空余dev也不会占有所有群集資源,换句话说,prod序列仍有25%的可以用資源用于紧急。大家注意到,eng和science2个序列沒有设定maximum-capacity特性,换句话说eng或science序列中的job很有可能会采用全部dev序列的全部資源(数最多为群集的75%)。而相近的,prod因为沒有设定maximum-capacity特性,它有可能会占有群集所有資源。Capacity器皿除开能够 配备序列以及容积外,大家还能够配备一个客户或运用能够 分派的最大资源总数、能够 与此同时运作是多少运用、序列的ACL验证等。

有关序列的设定,这在于大家实际的运用。例如,在MapReduce中,我们可以根据mapreduce.job.queuename特性特定得用的序列。假如序列不会有,我们在递交每日任务时便会接到不正确。如果我们沒有界定一切序列,全部的运用可能放到一个default序列中。

留意:针对Capacity生产调度器,大家的序列名务必是序列树中的最终一部分,如果我们应用序列树则不容易被鉴别。例如,在上面配备中,大家应用prod和eng做为序列名是能够 的,可是如果我们用root.dev.eng或是dev.eng是失效的。

2.3 FIFO Scheduler

yarn-site.xml文档

<property>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.fifo.FifoScheduler</value>

</property>

扫码关注:Java大数据信息与数据库管理,领到材料,学习大数据技术性。