本文由 发布,转载请注明出处,如有问题请联系我们! 发布时间: 2021-08-01java读取大文件内容-手把手教你java处理超大csv文件

加载中序

近期在提升我的开源系统实用工具,把PDF转化成word,有时会碰到一个难题,便是假如的PDF文档非常大,有好几百兆,怎样才能读得迅速,节约运行内存?所以我剖析较为了四种普遍的文档载入方法,并且用javaVisualVM专用工具开展了剖析。最终的结果是commons-io時间和空高效率高些。剖析依然来自于哪一个baeldung国外大佬。

下边我将得出一些阅读文章大文件的常见方式。

载入大文件的四种方式。

最先,我还在当地缩小了一个文件夹名称,大约500M。尽管并不是非常大,可是相对性还能够。

方式1:芭乐果读。

Stringpath="G:\java书籍及专用工具.zip";Files.readLines(newFile(path),Charsets.UTF_8);用芭乐果读非常简单,一行编码就能拿下。

转至jdk的bin文件目录寻找javaVisualVM专用工具,随后双击鼠标运作它。

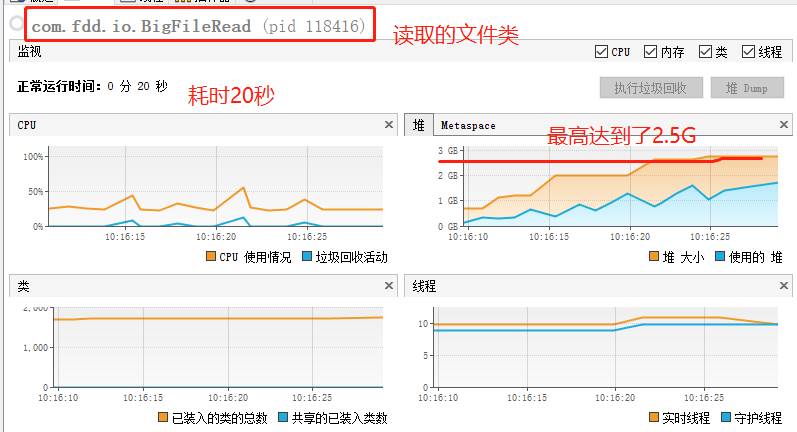

从图中能够看得出:

从图中能够看得出:用时:20秒。

堆内存:最大2.5G

CPU耗费:达到50%。

大家的500M文档较大堆内存为2.5G如果我们载入2G文档,大家的电子计算机很有可能会立即奔溃。

方式2: Apache Commons IO一切正常方式。

Stringpath="G:\java书籍及专用工具.zip";FileUtils.readLines(newFile(path),Charsets.UTF_8);这一方式也非常简单,也是一行编码。跑在下面,还剖析了一波:

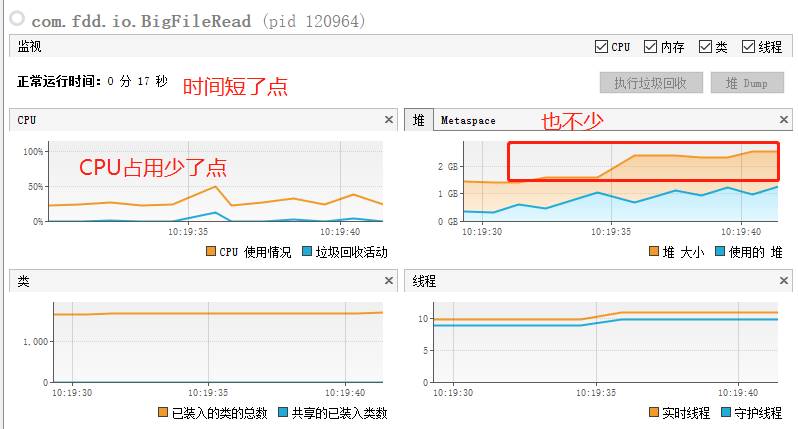

从图中能够看得出:

从图中能够看得出:用时:17秒。

堆内存:最大2.5G

CPU耗费:达到50%,运作流畅度约25%。

这类方法和上边的基本上一样,肯定并不是我需要的。

方式三:Java文件流。

FileInputStreaminputStream=null;Scannersc=null;try{inputStream=newFileInputStream(path);sc=newScanner(inputStream,"UTF-8");while(sc.hasNextLine()){Stringline=sc.nextLine();//System.out.println(line);}if(sc.ioException()!=null){throwsc.ioException();}}finally{if(inputStream!=null){inputStream.close();}if(sc!=null){sc.close();}}这类方法事实上是java中最普遍的方法,随后大家运作一波剖析:

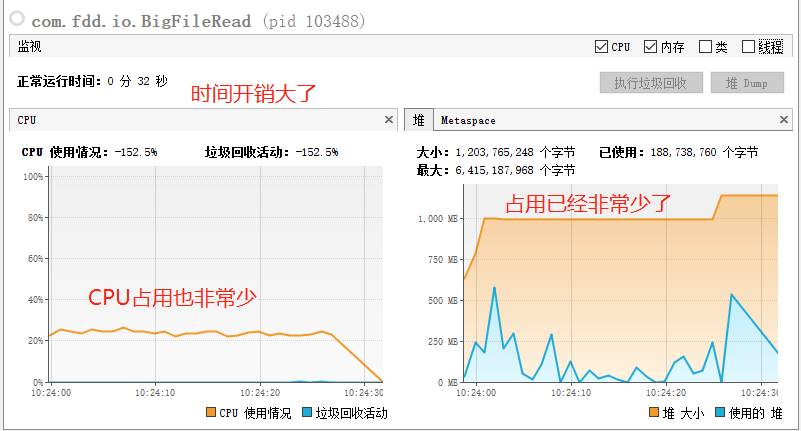

从图中能够看得出:

从图中能够看得出:時间耗费:32秒,翻番。

堆内存:最大1G,降低一半。

CPU耗费:运作顺畅25%上下。

这一办法的确非常好,可是時间上非常贵。

方式4: Apache Commons IO流。

LineIteratorit=FileUtils.lineIterator(newFile(path),"UTF-8");try{while(it.hasNext()){Stringline=it.nextLine();}}finally{LineIterator.closeQuietly(it);}那样编码看上去非常简单,因此立即运作一个wave:

从图中能够看得出:

从图中能够看得出:用时:至少16秒。

堆内存:达到650M,降低一半。

CPU耗费:运作顺畅25%上下。

好啦,就这样,牛。

结果

根据之前的剖析,我们可以得到一个结果,如果我们想载入一个大文件,挑选了失误的方法,很有可能会大大的占有我的运行内存和CPU,当文件十分大的情况下,便会造成出乎意料的难题。

因而,为了更好地彻底解决这个问题,有四种普遍的办法来载入大文件。根据剖析较为,发觉Apache Commons IO流是最高效率的方法。