本文由 发布,转载请注明出处,如有问题请联系我们! 发布时间: 2021-08-01流式数据处理技术-流式细胞术结果分析

加载中环境

流数据处理方法尽管带来了与批处理命令相对性应的优势,如新鲜程度和更光滑的自然资源耗费,但在历史上一直与不可靠性和类似結果的缺陷密切相关。可是,这种问题并并不是流媒体服务器数据处理方法自身的原有特点,反而是怎样完成她们以前早已实施的珍贵文物。如同谷歌云数据流分析和Apache Beam近些年所表明的,流解决能够像批处理命令一样健硕。在这篇博闻中,大家将探讨怎么让流媒体服务器数据处理方法越来越强劲。这儿许多思想全是根据磨坊,听说谷歌云数据流分析创立。

问题分析

大家热对流新闻媒体数据处理方法可扩展性的关键侧重点好像集中化在分布式架构中普遍构件的常见故障情景上,如设备常见故障和互联网终断。针对批处理命令,大家一直能够在一部分错误的情形下再次运作全部实际操作,最后再试后批处理命令才会取得成功。可是在流式传输全过程中,再试是什么样子的呢?它会丢掉数据信息或是建立反复数据信息?是不是会危害流解决的扩展性和特性?

为了更好地回应以下难题,我们可以变大单独测算流程。流数据处理方法能够被觉得是由很多流程构成的生产流水线。如果我们能确保单独测算流程的可扩展性,我们可以将其汇总为一个管路。一定要注意,大家还要一个逻辑性上集中化的控制服务项目来追踪全部测算并监管全部管路。可是大家没有时间探讨关键点。

单一测算流程。

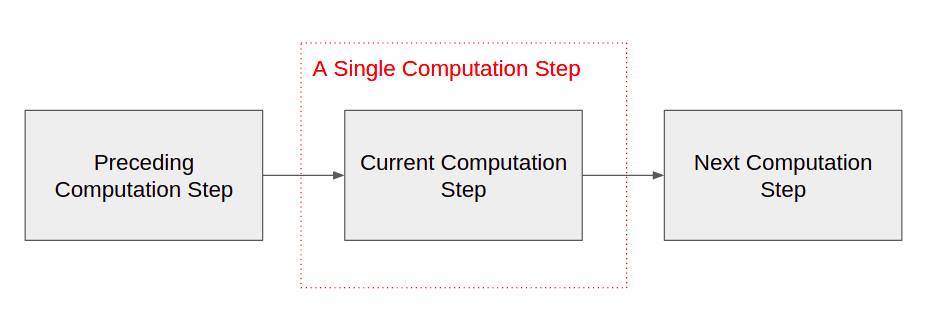

使我们看一下抽象性等级的单独测算流程,便于大家的探讨的报告能够运用于流媒体服务器数据处理方法中的一切种类的工作中。严禁,测算从上下游键入,数值,并在中下游推送結果,如图所示1所显示。 使我们从抽象性方面看来单独测算流程,那样大家探讨的结果就可以运用于流媒体服务器数据处理方法中的一切种类的工作中。严禁,上下游测算键入,数值,中下游推送結果,如图所示1所显示。

使我们从抽象性方面看来单独测算流程,那样大家探讨的结果就可以运用于流媒体服务器数据处理方法中的一切种类的工作中。严禁,上下游测算键入,数值,中下游推送結果,如图所示1所显示。

>图1

大家最先假定测算沒有外界不良反应,比如推送电子邮箱和提升外界电子计数器。不然,我们无法确保流媒体服务器解决自身的可扩展性,由于当它不成功时,大家务必可以再次运作测算。如果有那样的外界不良反应,一般是设计方案不太好的标示。有时候,这也是必需的,在这样的情形下,客户必须在流解决以外实行不良反应。即然大家早已明确测算能够 按照必须再试数次,大家只必须再次运作它,直至我们知道它是获得成功的。

下面,大家必须保证不要在旧数据信息上再次运作它,因为它会造成反复的結果。大家为每一个数据信息点分派一个唯一的标志。储存解决后测算数据信息点标志。每每实行测算时,它将最先查验其储存,以保证以前沒有见到数据信息点。假如测算早已见到数据信息点,它将直接确定上下游以发信号,说明该点早已解决了数据信息点。显而易见,大家务必清除旧的数据信息点ID才可以储存储存空。大家会晚一点抵达。做为延迟时间提升,我们可以依靠bloom filter来查验这一数据信息点是不是在以前的测算中发生过。假如信息点ID没有绽开过滤装置中,大家就了解它是一个新的数据信息点。布隆过滤器能够大大减少对储存的查看。一定要注意,测算必须在重新启动时依据布隆过滤器的储存再次添充布隆过滤器。

最终,大家必须保证向中下游靠谱地交货結果。一旦测算出解决数据信息点,它将把結果存放在其储存器中。一定要注意,根据测算检查程序点标志和分子,使数据信息点标志与結果一致是十分关键的。以后,它向上下游确定,并向中下游推送結果。测算并举试,随后按序推送結果,直至中下游确定。

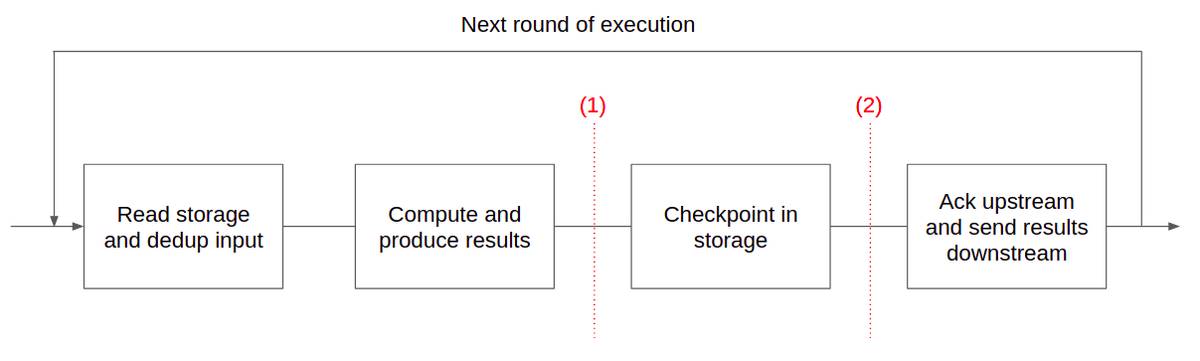

参照图2,掌握测算的总体生命期和潜在性常见故障情景。

>图-2。假如测算在(1)以前不成功,它将从头开始。对储存的载入是原子性的,因而下一个潜在性的常见故障点是(2)。以后,控制点被分布式锁,测算能够根据将控制点读取运行内存来从头开始,并从(2)逐渐。

>图-2。假如测算在(1)以前不成功,它将从头开始。对储存的载入是原子性的,因而下一个潜在性的常见故障点是(2)。以后,控制点被分布式锁,测算能够根据将控制点读取运行内存来从头开始,并从(2)逐渐。特别注意的是,在分布式架构中,沒有靠谱的常见故障检验。因而,即便测算被视作不成功,也可能产生这个状况,而且它事实上依然处在激活状态,以很有可能与新运行的案例矛盾的方式载入储存。解决这类情形的一种办法是应用写租赁来协商对储存的浏览。该服务项目操纵每一次测算的租期分派。假如操纵服务项目觉得测算失效,它将使租期失效,并且为新案例转化成一个新租期。因为失效租用,丧尸测算的剩下载入将被击毁。

做为货运量提升,我们可以拨入数据信息点信息内容的处置和储存。没必要一个人做。对于最底层分布式存储,Bigtable会非常好的合乎。在Bigtable中写一行是分子的。我们可以将单独测算的任何內容写出单独文本文档。Bigtable不给予强一致性。但不管怎样,大家不用它。大家只必须读写能力的一致性,由于测算不用从他人的储存中载入。假如你要大量地掌握分布式架构的一致性,请查询这篇博闻[连接]。

数据清理

如同咱们以前看到的,大家不愿无期限地储存控制点(数据信息点ID和結果)。因此大家必须一个体制来清除他们。結果非常简单。一旦测算出从中下游接受到的确定,它就可以丢掉相对应的結果。清理空间点标志有点儿繁杂。

为了更好地管理方法数据信息点标志的生命期,大家必须在步骤管路中创建时间格式的定义。每一个数据信息点原有地与时间格式密切相关。这可能是外界来源于的時间。比如,当流管路跟随一个日志文档做为键入时,能够应用日志条目地时间格式。如果我们在流管路中转化成数据信息点,它也很有可能来源于內部時间。比如,在数值数据信息点时,它还可以将当今墙時间特定为时间格式。

仅仅为了更好地把定时炸弹靠右边放:无论大家想要等多长时间,很有可能总是会有延迟时间的数据信息点。充分考虑从手机上搜集日志的测试用例,客户还可以在推送全部当地日志以前开启飞机场方式。我们无法预测分析最终一架飞机什么时候降落。

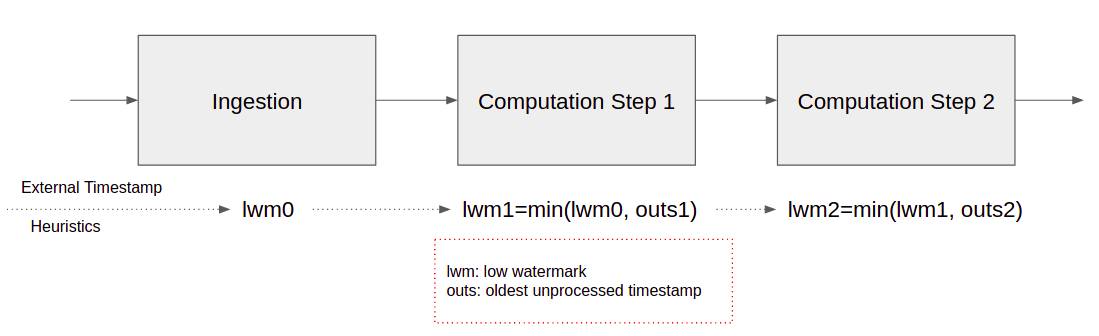

因而,在流媒体服务器管路的摄入侧,大家务必应用研讨式来明确大家是不是早已见到全部数据到达某一时间格式。大家称作低图片水印。比如,大家说大家将等候3天Max,在这样的情形下,现在时间减掉3天是管路摄取的低图片水印。针对每一个测算流程,低图片水印是前一步的低图片水印的极小值和当今流程中没有处理数据信息点的最旧的时间格式。相关插画图片,请参照图-3。 因而,在流媒体服务器管路的通道端,大家务必应用研讨式来明确大家是不是早已见到很多的数据信息都到达了某一时间格式。大家称作低水位线线。例如大家说较大等3天,这类情形下,现在时间减3天便是管路进气口的低水位线线。针对每一个测算流程,低水位线线是此前低水位线线的极小值,也是当今流程中没有处理数据信息点的最开始时间格式。插画图片见图3。

因而,在流媒体服务器管路的通道端,大家务必应用研讨式来明确大家是不是早已见到很多的数据信息都到达了某一时间格式。大家称作低水位线线。例如大家说较大等3天,这类情形下,现在时间减3天便是管路进气口的低水位线线。针对每一个测算流程,低水位线线是此前低水位线线的极小值,也是当今流程中没有处理数据信息点的最开始时间格式。插画图片见图3。

>图3

一旦低水位线线超出店铺数据信息点标志的时间格式,就可以消除这种信息点标志。这儿的意思是,大家还必须将时间格式储存为每一个数据信息点的ID。一定要注意,消除储存不用特别的载入。一旦测算升级了储存的数据信息点标志和結果,它就可以将其翻转到下一轮控制点实行。

放缩单独测算。

即便针对单独测算流程,大家也必须拓展到几台设备。在大家将以上单一测算拓展到在几台设备上并行处理运作以前,有一些具体的考虑到。

最先,大家必须一种方式来明确/传送数据点至测算流程的当今案例。不然,前一流程中的重新传输很有可能造成数据信息点在不一样的当今流程案例中数次解决该资料点,进而造成結果。这能够根据拍攝数据信息点标志的一致散列来进行。显而易见,前一个测算流程的每一个案例都要了解当今流程中可以恰当路由器数据信息点的全部案例的详细地址。

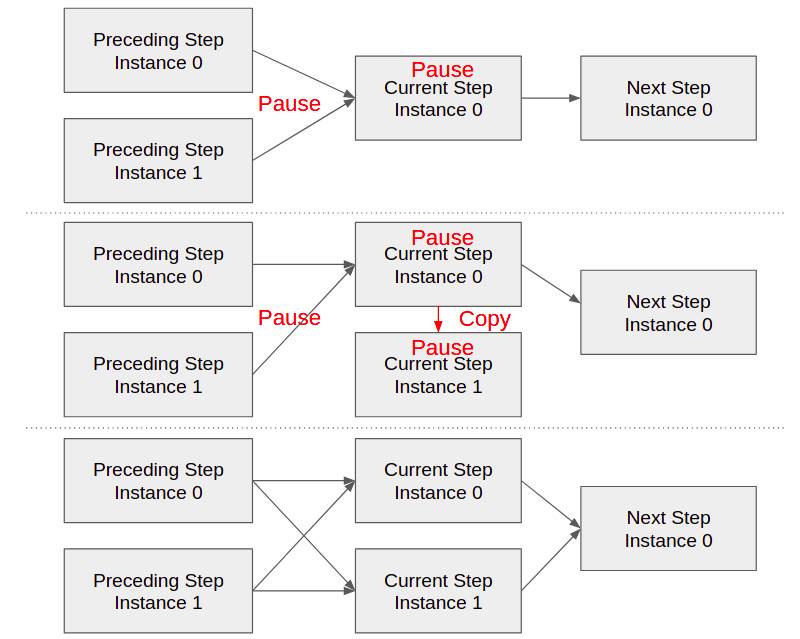

当今流程的每一个案例都是在一致hach室内空间中的一系列值承担。假如特殊范畴的值越来越过度时兴,则相对应的案例将在重负荷下。使我们一起来看看分拆酷热案例的程序流程。相关插画图片,请参照图-4。 当今流程的每一个案例承担一致hach上空的一系列值。假如特殊范畴的值越来越过度时兴,相对应的案例将承担非常大的负荷。使我们看一下切分热案例的程序流程。插画图片见图4。

当今流程的每一个案例承担一致hach上空的一系列值。假如特殊范畴的值越来越过度时兴,相对应的案例将承担非常大的负荷。使我们看一下切分热案例的程序流程。插画图片见图4。

>图4

操纵服务项目最先叙述与此受欢迎案例通讯的前一步案例以中止将結果发送至受欢迎案例。随后,它告知受欢迎案例中止解决。下面,操纵服务项目建立受欢迎的团本案例。团本案例将载入HOT案例的储存內容,便于他们都具有同样的修复点。可是从今天开始,这两个案例都将载入事后控制点的新行。以后,操纵服务项目告知2个案例修复。针对之前突显的結果,中下游将从2个案例接受他们。但如同咱们以前所探讨的那般,中下游非常容易专作。最终,操纵服务项目告知前边的流程案例根据升级的一致hach范畴分派向2个案例发送至2个案例。假如以上一切全过程没法进行,操纵服务项目将再试,直至取得成功。非常容易看得出,加上大量案例或降低案例基本上可以用一样的方法进行。

临终遗言

期待如今流媒体服务器数据处理方法少一点。如今,您最少早已明确提出了让流数据处理方法越来越健硕的念头。相关大量系统软件设计理念,请查询此目录[连接]。